Personalisiertes 3D-Audio – Der heilige Gral namens HRTF

Inhalt

Ich wollte schon immer einen Artikel über personalisiertes 3D-Audio schreiben. Aber ehrlich gesagt ist das Thema so nischig, dass ich es nicht für so relevant hielt. Außerdem habe ich eine ganz eigene Meinung dazu, aber später mehr zu den Vor- und Nachteilen.

Einer der Gründe dafür ist, dass man, wenn man über personalisiertes räumliches Audio sprechen will, um eine Sache nicht herumkommt: HRTF. Auch bekannt als kopfbezogene Übertragungsfunktion. Klingt nach einer komplizierten Definition. Und das ist sie auch!

Aber das Weiterlesen hier lohnt sich. Apple hat gerade personalisiertes 3D-Audio, also den Raumklang, angekündigt. Damit wird es cool, ein Bild von deinen Ohren zu machen. Klingt neu in innovativ? Ja, aber es gibt Anbieter die machen es schon seid Jahren, also aufgepasst!

Update:

- 22/09: Im neuen iOS 16 gibt es nun das Feature. Unten im Artikel gibt es mehr Information, wie Apple sich dem Thema personalisiertes 3D-Audio angenähert hat.

- 22/09: Immerse Gaming | Logitech ist die Spatial-Audio-Software, die kamerabasiertes Head-Tracking für alle Logitech G- und Astro-Headsets, ermöglicht. Das schließt alte und neue headsets mit ein. Mit KI-gesteuerter personalisierter HRTF sowie der dynamischen Kopfverfolgung (Head-Tracking) mit niedriger Latenz. Möglich macht es jede Webcam und und hinzu kommt die Option, räumliches Audio auf Twitch, Streamlabs und mehr zu streamen.

Wie funktioniert personalisiertes räumliches Audio?

Jeder Mensch hat ein anderes Paar Ohren. Vor allem die Ohrmuschel, auch Auricula auris genannt, ist dafür verantwortlich, wie wir den Klang unserer Umgebung wahrnehmen. Natürlich gibt es noch eine Menge anderer Dinge, die gemessen werden müssen. So wie die Kopfgröße, die Schultern oder auch der innere Gehörgang.

Ein bisschen wie ein Fingerabdruck, der nur einmal vorkommt, hören wir die Welt also alle ein bisschen anders. Für die herkömmliche Audiotechnik ist das nicht so relevant. Genau wie bei Lautsprechern oder Kopfhörern. Aber bei Spatial Audio müssen wir plötzlich diesen winzigen Unterschied berücksichtigen, den wir alle haben.

Wie hören wir räumlich?

Es gibt drei Hauptfaktoren, die dafür ausschlaggebend sind, dass wir Schall als 3D-Audio wahrnehmen können. Diese sind:

- ITD: Interaurale Zeitdifferenz

- ILD: Interauraler Pegelunterschied

- HRTF: Kopfbezogene Übertragungsfunktion

Das klingt sehr abstrakt, aber ich möchte ein einfaches Beispiel geben. Mann stelle sich vor, man hört ein Auto, das von links kommt. Für die Akustik ergibt sich folgendes Klangblid:

- ITD: Die Schallwellen erreichen das linke Ohr vor dem rechten Ohr. Denn unser linkes Ohr ist in diesem Beispiel näher am Auto, logisch oder?

- ILD: Der Schall ist auf dem linken Ohr auch lauter. Das liegt daran, dass unser Kopf in diesem Beispiel für unser rechtes Ohr ein bisschen wie eine Wand ist. Daher wird der Schall abgeschattet und ist rechts leiser.

- HRTF: Auch wegen unseres Kopfes würde unser Gehirn unterschiedliche Frequenzkurven vom linken und rechten Ohr messen.

Lange Rede kurzer Sinn. Mit unseren beiden Ohren kann unser Gehirn Klangunterschiede zwischen links und rechts feststellen. Wir haben unser ganzes Leben über gelernt, wie sich dieser Unterschied anhört. Deshalb können wir Schallquellen im Raum lokalisieren. Zum Beispiel ein Klopfen an der Tür, Menschen, die sich unterhalten, oder das Auto für dieses Beispiel.

Bisher war es nicht wirklich nötig, diesen Klang zu personalisieren. Denn alle Beispiele, die ich gerade genannt habe, funktionieren bei Lautsprechern oder natürlichen Geräuschen in unserer Umgebung. Was aber, wenn wir 3D-Audio auf Kopfhörern wiedergeben wollen?

Was ist binaurales Audio?

Willkommen in der Welt des binauralen Audios! Es ist im Grunde eine spezielle Version von Stereo. Das heißt, wir verwenden auch nur zwei Audiokanäle. Da wir auch nur zwei Ohren haben, funktioniert diese Technik. Aber eben nur für Kopfhörer, der Schall muss direkt auf die Ohren treffen. Es darf kein Raum dazwischen sein, wie bei der Wiedergabe über Lautsprecher.

Hey, aber was ist mit Surround? Warum braucht man Mehrkanalton wie 5.1.? Auf Lautsprechern benötigt man mehrer Audiokanäle, ja! Aber es besteht keine Notwendigkeit, den Klang hier zu personalisieren. Da die Personalisierung bereits in unseren Ohren stattfindet. Selbst wenn sich mehrere Personen in einem Raum befinden, hören wir den Ton ja unabhängig voneinander.

Wie funktioniert räumliches Audio für Kopfhörer?

Wenn wir das Surround-Sound-Erlebnis auf Kopfhörern transportieren wollen, brauchen wir eine gewisse Rendering-Magie. Und genau das hat Apple zum Beispiel mit Dolby Atmos Music getan. Oder Dolby Atmos nur für Filme. Es nimmt das räumliche Audiosignal – das alle dreidimensionalen Audiodaten enthält – und rendert es auf zwei Audiokanäle. Das Ergebnis ist binaurales Audio speziell für Kopfhörer. Manche nennen es auch Kopfhörer-3D

Damit das funktioniert, brauchen wir die HRTF. Sie können sich die Verarbeitung wie folgt vorstellen: Das Abspielgerät – das kann eine App, ein iPhone oder ein Fernseher sein – liest die Audioinformationen. Anhand der Metadaten weiß der Decoder, wo sich die Audioobjekte im Raum befinden. Nun berechnet der Renderer

„OK, wie würden die Audioobjekte für einen Menschen klingen?“

Mit diesen komplizierten bercheneten Filterkurven klingen die Audioobjekte auf Kopfhörern plötzlich so, als käme es zum Beispiel von hinten. Das ist es, was klassisches Stereo nicht kann. Wir haben nur links und rechts. Außerdem würden wir den Klang als im-Kopf-Lokalisation wahrnehmen, weil unserem Gehirn die Rauminformationen fehlen.

Nur mit dieser HRTF-Wiedergabe verfügt unser Gehirn über den notwendigen Datensatz, um zu verstehen, woher der Klang im Raum kommt.

Warum personalisiertes 3D-Audio ein entscheidender Fortschritt ist

Wie bereits erwähnt, werden viele Echtzeitberechnungen durchgeführt, um räumliches Audio zu ermöglichen. Aber um all diese Daten zu generieren, verwendet der Renderer ein 3D-Modell eines Kopfes. Ein bisschen wie ein Kunstkopfmikrofon, aber virtuell.

Leider beruhen alle Daten nur auf Durchschnittswerten. Die Software-Ingenieure haben also eine Menge menschlicher Köpfe und Ohren vermessen. Dann haben sie ein Modell erstellt, das so vielen Menschen wie möglich nahe kommt.

Die Chancen stehen also gut, dass das räumliche Audioerlebnis, das Sie mit Apple haben, für einen gut funktioniert. Aber wenn man einen „besonderen Kopf“ hat, wird die 3D-Klangtechnik für auch nicht so wirklich gut funktionieren. Denn Ihre physischen Ohren unterscheiden sich zu sehr von den Zahlen, die für das Rendering verwendet werden.

Wie kann ich auf personalisiertes 3D-Audio hören?

Dazu brauchen wir die richtigen Inhalte. Es ist also mal wieder immersiver Content gefragt, worüber ich in meinem Blog hier ständig berichte. Die gute Nachricht ist, dass es viele davon gibt. Im Grunde genommen kann jeder Mehrkanal-Audioinhalt in personalisierten Klang umgewandelt werden, wie z. B:

- Surround-Sound aus Filmen (Auro 3D, Dolby Atmos Music, MPEG-H)

- Ambisonics aus 360-Videos (YouTubeVR, Facebook360)

- interaktives Audio aus Spielen oder VR (Unity, Unreal, Stem, Playstation)

Das personalisierte Audio muss nur noch in eine Softwarelösung implementiert werden, bevor der Klang wirklich auf den Kopfhörer trifft. Man kann übrigens jeden beliebigen Kopfhörer wählen. Es werden also keine Apple Airpods für personalisiertes 3D-Audio benötigt. Aber sie ermöglichen wiederum das Head-Tacking, was das immersive Audioerlebnis natürlich verbessert.

Welche personalisierten 3D-Audio Softwarelösungen gibt es?

Natürlich gibt es nicht nur Apple. Viele Hersteller haben auf diesem Gebiet gearbeitet, daher hier ein Überblick. Ich werde mehr Text hinzufügen, sobald ich dazu komme.

Genelec Aural ID, SOFA

Genelec, ein Hersteller von Lautsprechern, hat als erster eine Pipeline entwickelt, mit der man einfach Fotos und Videos von seinen Ohren machen kann. Dann schickt man die Dateien über die App an das Unternehmen und erhält ein 3D-Modell seiner Ohren. Dieses 3D-Modell ist eine sogenannte Sofa-datei, die Sie mit Plugins in Ihrer Audioworkstation kombinieren können.

Embody IMMERSE™.

Embody hat eine gute Arbeit bei der Implementierung personalisierter Sounds für Spiele geleistet. Das Unternehmen bietet eine Softwarelösung an, die 5.1-Surround-Sound nutzt, der von den meisten Spielen verwendet wird. In Games ist personalisiertes 3D-Audio also schon angekommen.

Immerse ermöglicht Head-Tracking über die Webcam und verfügt über Voreinstellungen, die am besten mit Logitech-Headsets funktionieren. Es richtet sich an Streamer und Content Creators, zum Beispiel auf Twitch.

Aber sie wollen nicht nur Gamer ansprechen. Für Audio-Profis wurde die Technologie in Steinbergs Digital Audio Workstation integriert.

Dolby pHRTF

Das neue Tool von Dolby ermöglicht es Tonschaffenden, Dolby Atmos-Inhalte über Kopfhörer zu hören. Mit Dolby Atmos Personalized Rendering können Mischer jetzt räumliche Audiomischungen jetzt auch über Kopfhörer mixen. Zum ersten Mal bei Dolby Atmos wird das Hörerlebnis mit einer personalisierten HRTF (Head Related Transfer Function) gerendert.

THX Ltd. und VisiSonics kooperieren

THX hat bestimmte 3D-Audio- und Personalisierungstechnologien von VisiSonics lizenziert und baut sie in seine Produkte ein. Die VisiSonics-Techniken werden in THX® Spatial Audio-Tools für Spieleentwickler und Musikproduzenten eingesetzt und verbessern die THX-Audio-Personalisierung für Headset-Hersteller.

Sony 360 Reality Audio Kopfhörer

Die Kopfhörer-App von Sony, die mit Köpfhörern wie dem WH-1000XM4, XM5 und WF-1000XM4 verwendet wird, macht etwas ähnliches. Hier wird man aufgefordert, Fotos von beiden Ohren zu machen. Damit wird der Klang des hauseigenen räumlichen Audioformats, Sony 360 Reality Audio (360RA) optimiert.

Afaic Crystal River Engineering

Sie waren wahrscheinlich die ersten, die überhaupt an diese Raketentechnologie gedacht haben. Warum Rocket Sciene? Nun, convolvotron™ ist ein beliebtes HRTF-basiertes räumliches Audiosystem, das für die NASA entwickelt wurde. Es wurde in den neunziger Jahren von Crystal River Engineering hergestellt. Mehr über abgespacte Audiotechnologie und personalisierte HRTF gibt es hier.

Apple personalisiertes 3D-Audio

Da Apple eng mit Dolby zusammenarbeitet, stehen die Chancen gut, dass es auch hier eine Zusammenarbeit geben wird. Informationen werden nach der WWDC folgen. Aktivieren kann man die funktion unter „Benutzerdefinierter Raumklang“ in den Airpods Einstellungen.

Apple plant, dass man selber sein Ohren scannt, dessen Form analysiert und diese Daten dann nutzt. Also ähnlich dem Ansatz von Genelec, aber iPhones haben die Lidar-Technologie, was ein Vorteil sein könnte. Sie haben schließlich die TrueDepth Kamera Systeme mit der Selfie Kamera und Infrarot Emitter.

Viele Mac-Tech-Rezensionsseiten wie nicht Audio-Experten glauben, dass dies nur eine Funktion für neuere Apple-Kopfhörer sein wird. Ich hingegen denke, dass es sich nur um ein Software-Update ohne neue Hardware handeln könnte. Aber wie wir die Apple-Politik kennen, uns zum Kauf neuer Produkte zu zwingen … mal sehen.

Und hier ist auch schon das Update. Anders, als viele selbsternannte Fachmagazine behaupten, benötigt man nicht die neuen Airpods Pro 2. Ich konnte personalisiertes 3D-Audio erfolgreiche mit meinen Airpods Pro der ersten Generation einrichten. Die Einrichtung ist selbsterklärend, man muss lediglich seine Airpods verbunden haben und ins entsprechende Menu gehen. Mehr Informationen gibt es auf der Apple Support Seite, die es aktuell noch nicht auf Deutsch gibt. Daher hier die Übersetzung:

Welche Hardware brauche man für Apple’s personalisiertes Spatial Audio? Um Personalized Spatial Audio einzurichten, benötigen Sie ein iPhone mit iOS 16 und die TrueDepth Kamera. Nachdem Sie sich mit Ihrer Apple ID angemeldet haben, können Sie Personalized Spatial Audio auf diesen Geräten verwenden:

- AirPods Pro (1. oder 2. Generation), AirPods Max, AirPods (3. Generation) oder Beats Fit Pro

- Audiovisuelle Inhalte aus einer unterstützten App

- Ein iPhone oder iPod touch mit iOS 16 oder neuer; ein iPad mit iPadOS 16.1 oder neuer; eine Apple Watch mit watchOS 9 oder neuer; ein Apple TV mit tvOS 16 oder neuer; oder ein Mac Computer mit Apple Silicon und macOS Ventura

Wo finde ich personalisiertes 3D Audio in den Einstellungen?

-

- Gehen Sie auf Ihrem iPhone zu Einstellungen > [Ihr Spatial Audio-fähiges Gerät] > Personalisiertes Spatial Audio > Personalisiertes Spatial Audio einrichten.

-

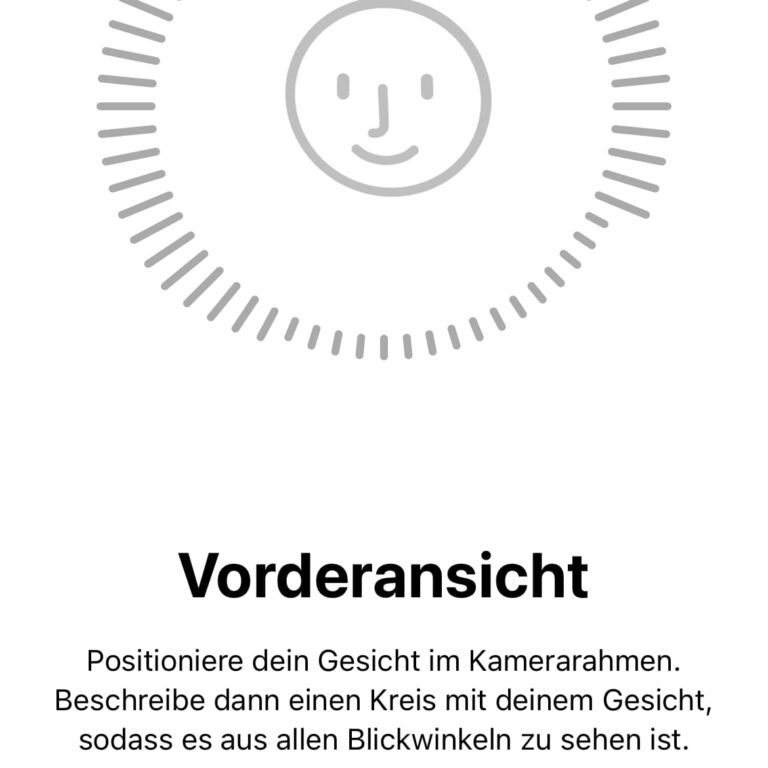

- Um die Frontansicht aufzunehmen, halten Sie Ihr iPhone etwa 12 cm direkt vor sich. Positionieren Sie Ihr Gesicht im Kamerarahmen und bewegen Sie dann langsam Ihren Kopf in einem Kreis, um alle Winkel Ihres Gesichts zu zeigen. Tippen Sie auf Weiter.

-

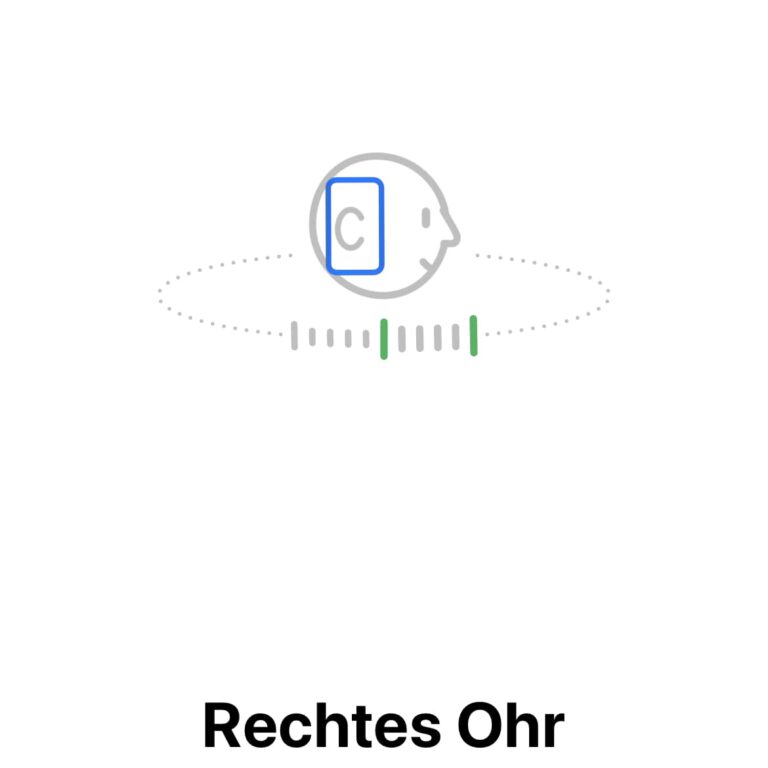

- Um Ihr rechtes Ohr zu erfassen, halten Sie Ihr iPhone mit der rechten Hand. Bewegen Sie Ihren rechten Arm um 45 Grad nach rechts und drehen Sie dann Ihren Kopf langsam nach links. Um einen Blick auf Ihr linkes Ohr zu werfen, nehmen Sie das iPhone in die linke Hand. Bewegen Sie Ihren linken Arm um 45 Grad nach links und drehen Sie dann Ihren Kopf langsam nach rechts. Audio- und visuelle Hinweise helfen Ihnen bei der Einrichtung.

Was man über personalisiertes räumliches Audio wissen müssen

Alles in allem wird diese Technologie helfen, 3D-Klänge auf Kopfhörern besser zu lokalisieren. Sie bietet ein noch besseres Erlebnis für alle immersiven Medien, die mit mehrkanaligen Audio-Workflows gemischt wurden. Der Raumklang wird sich einfach natürlicher anfühlen. Das ist ein bisschen wie die Suche nach dem perfekten Schuh, für den es keine Einheitslösung gibt.

Wenn ich über Personalisierung spreche, muss ich NGA (next-generation audio) mit MPEG-H erwähnen. Eine bessere Lokalisierung von 3D-Audioobjekten ist nur eine Art der Anpassung, die wir vornehmen können. Man stelle sich vor, man könnte auch die Dauer ändern oder zu laute Musik für sich selbst korrigieren? Mehr mit NGA-Audio gibt es im Artikel zu objektbasiertem Audio zu lesen.

Aber was bedeutet das alles? Wie kann man ein kreatives Klangerlebnis mit personalisiertem Sound schaffen? Ich helfe gerne dabei, also zögern Sie nicht mich zu kontaktieren!

Kontakt aufnehmenVerwandte Blogartikel

Spatial 3D Audio Apps - Apple Airpods Pro, Galaxy Buds Head tracking

Apple Spatial Audio - Which device or tool gives you the 3D effect?

Hearables with Spatial Audio - and more smart Earbuds Technology

Wie binaurales Hören funktioniert um 3D Sound zu lokalisieren

Head Tracking 3D Audio - Kopferfassung für Surround Kopfhörer